Heimathafen - Finde Unternehmensinformationen durch chatten!

Unser KI-gestützter Heimathafen-Chatbot ermöglicht eine effiziente und präzise Wissensdatenbankabfrage für unternehmensinterne Informationen. Mitarbeiter können gezielt Fragen wie Wie melde ich mich krank? oder Wann ist die Weihnachtsfeier? stellen, woraufhin der Chatbot relevante Informationen aus internen Dokumenten extrahiert und eine verständliche Antwort generiert. Durch den Einsatz von Retrieval-Augmented Generation (RAG) kombiniert das System eine vektorbasierte Dokumentenretrieval-Technologie mit generativer KI, um stets die aktuellsten und relevantesten Inhalte bereitzustellen.

Eine zentrale Stärke des Chatbots ist die automatische Quellenreferenzierung: Neben der Antwort wird die Datei oder Dokumentation angegeben, aus der die Information stammt. Dies wird durch optimiertes Prompt Engineering ermöglicht, das eine präzise und transparente Antwortstruktur sicherstellt. Die zugrunde liegende Architektur erlaubt eine semantische Suche über verschiedene unternehmensinterne Datenquellen wie SharePoint, Intranet-Wikis oder andere Wissensdatenbanken.

Durch die Kombination dieser Technologien bietet der Chatbot eine intuitive und verlässliche Möglichkeit, Unternehmenswissen effizient bereitzustellen, reduziert wiederkehrende Anfragen an HR-, IT-Support-Teams oder Kollegen und steigert die Produktivität im Arbeitsalltag.

Sollte die Live Demo nicht funktionieren, dann klicke hier.

Problemstellung und Use Case

- Verstreute Informationsquellen: Unternehmen arbeiten häufig mit isolierten Datenquellen, was die Suche nach wichtigen Informationen zeitaufwendig und fehleranfällig macht.

- Wiederkehrende Anfragen: Standardisierte Fragen zu internen Prozessen, wie Krankmeldungen oder Terminen, belasten HR-, IT-Support-Teams und Kollegen.

- Bedarf an schneller und aktueller Information: Mitarbeiter benötigen einen schnellen, verlässlichen Zugang zu den neuesten und relevantesten Inhalten, ohne mehrere Systeme durchsuchen zu müssen.

Mit welchen Technologien haben wir gearbeitet?

Wir verwenden die folgenden Technologien, um unser Projekt zu betreiben:

- LangChain als Framework

- OpenAI für die LLM Schnittstelle

- Eigene Crawler um unterschiedliche Daten aus unterschiedlichen Quellen zu beschaffen

- Chroma DB als Vektordatenbank

- FastAPI für das Backend

- Sharepoint für das Frontend, native Integration in das Suchfeld

- Azure Cloud für das Hosting

Produktschaubild

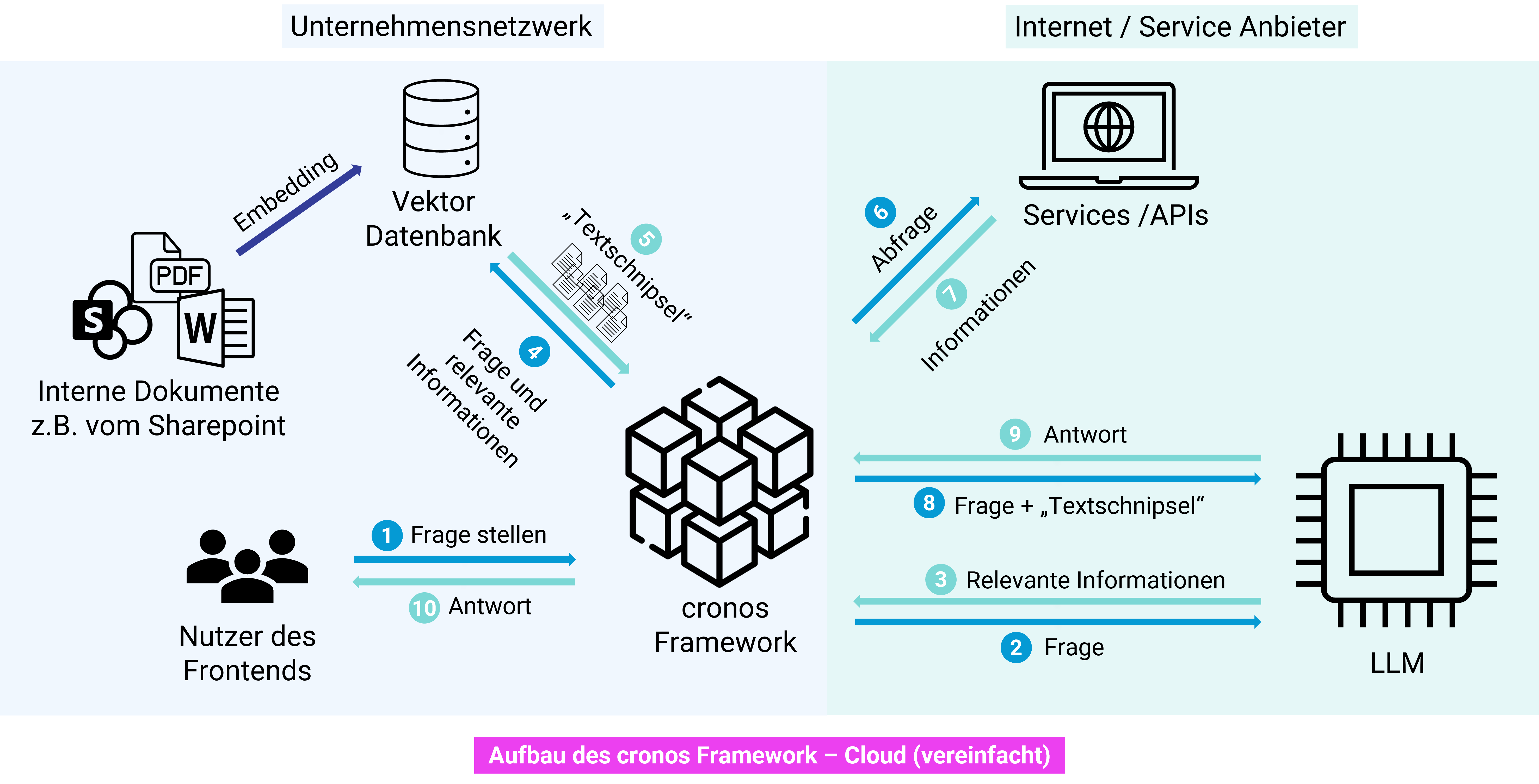

Architektur - Cloud Deployment

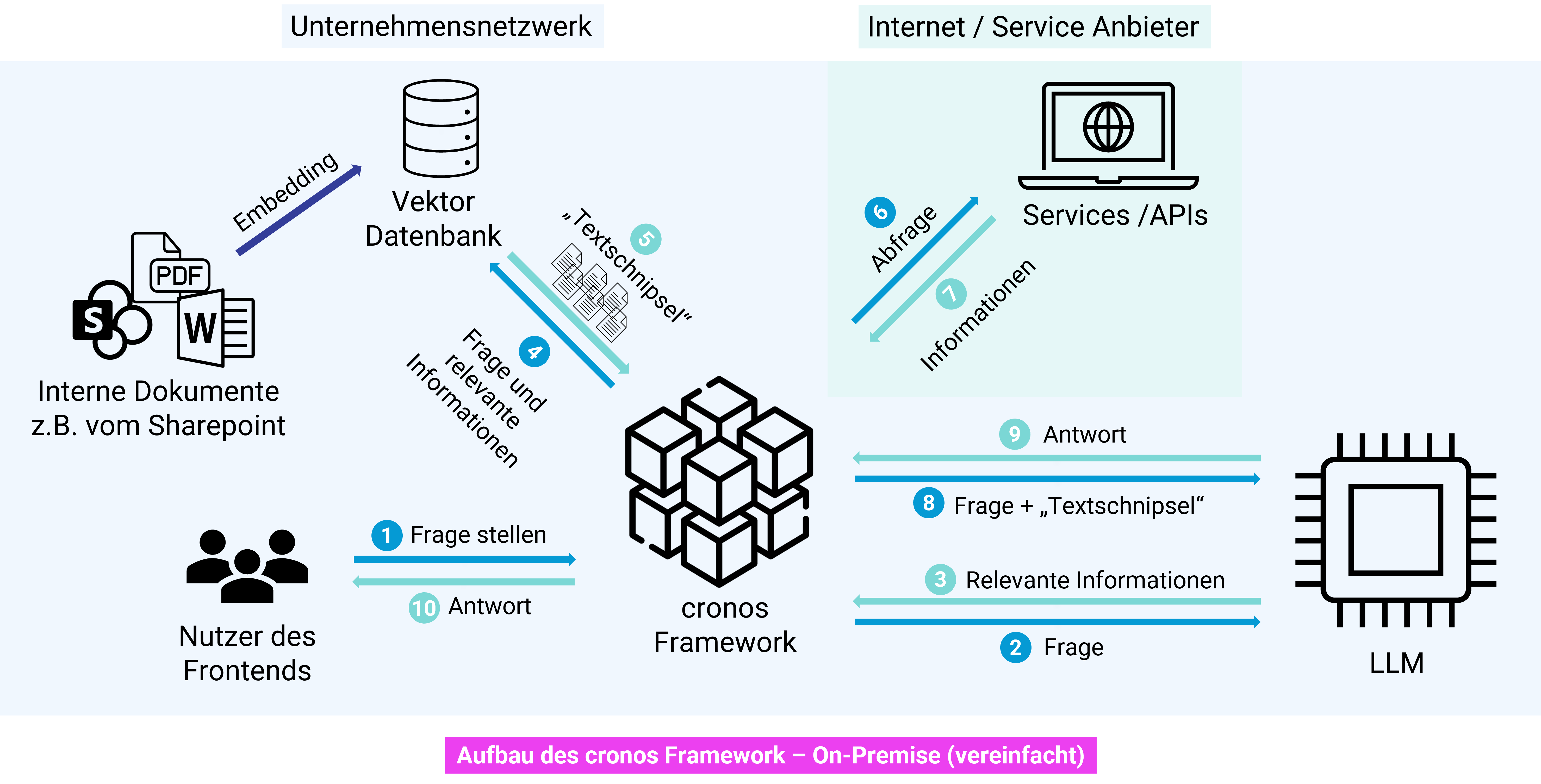

Architektur - On-Premise Deployment

Mitwirkende

Projektleitung & Entwicklung

Lead Developer

Entwicklung

Entwicklung

Erfahrungsberichte und Learnings

Standardisierung und Modularität - Entwicklung eines Best Practice Leitfadens für Standarisierung und Qualität.

Anbinden von verschiedenen Datenquellen - Jedes Dateiformat braucht eine separate Bearbeitung (Metadaten, Textsplitter)

Bestehende Frameworks zu starr - Eigene Entwicklung notwendig, um Anforderungen zu erfüllen.

Alle Chunks werden für Antwort verwendet - Prävention durch Zusammenfassung pro Chunk durch das LLM.

Chatbot versteht Kontext nicht - Rechtschreibprüfung und Kontext-kompression der Frage stabilisieren Antworten.

Halluzinationen vom LLM - Erneutes Filtern von Dokumenten und Aufbau von Alternativfragen erhöhen Qualität.

Chatbot Integration / Frontend - Welche Informationen kann der Chatbot erhalten und welche soll er wiedergeben.

Persona ist zu sprunghaft - Dynamisches anpassen des Prompt Templates bevor der User prompt abgesendet wird.

Kundenfähigkeit

Status

Das Projekt Heimathafen befindet sich in einem fortgeschrittenen Prototypenstadium.

Einrichtung des Projekts beim Kunden

- Deployment der API-Anwendung: Installation der FastAPI-basierten REST-API inklusive Konfiguration der LLM-Schnittstelle und der Dokumentenextraktion mithilfe der LangChain-Bibliotheken. Dies kann als Docker-Container, über Azure-Container-Apps oder mittels virtueller Maschinen erfolgen.

- Konfiguration der Informationsquellen: Einrichtung von ChromaDB zur Speicherung und schnellen semantischen Suche der aus internen Dokumenten generierten Vektoren.

- Einrichtung der Datenquellenanbindung: Integration interner Dokumentenquellen wie SharePoint, Intranet-Wikis oder anderer Wissensdatenbanken zur automatisierten Extraktion und Anreicherung von Metadaten.

- Anbindung an interne Systeme: Über REST-APIs und Microservices wird eine nahtlose Verbindung zu bestehenden IT-Systemen hergestellt, um den Zugriff auf Unternehmensinformationen zu optimieren.

- Sicherheits- und Authentifizierungskonzepte: Implementierung von Sicherheitsmaßnahmen wie SSO, OAuth und datenschutzkonformen Prozessen, um den Schutz und die Integrität der Unternehmensdaten sicherzustellen.

- Kontinuierliche Überwachung: Implementierung von Monitoring- und Logging-Lösungen zur Beobachtung der Systemperformance und Sicherheit.

- Hosting in der Kunden eigenen Cloud: Wir sind nicht nur an die Azure Cloud gebunden, sondern können jegliche Hosting Lösung des Kunden verwenden.

Systeminstallation und Konfiguration

Integration in die bestehenden IT-Landschaft

Deployment und Monitoring

Beteiligte Positionen

- Gesamtkoordination des Projekts, Abstimmung zwischen internen Teams und Kunden sowie Planung und Umsetzung der Roadmap.

- Weiterentwicklung des Systems, Implementierung von Integrationen, Optimierung der Infrastruktur und Sicherstellung eines reibungslosen Deployments und Betriebs.